Перед установкой

В этом разделе приведены общие сведения о программных компонентах для целевых машин (Умный OCR / NLP) и системные требования к таким машинам.

Общие сведения

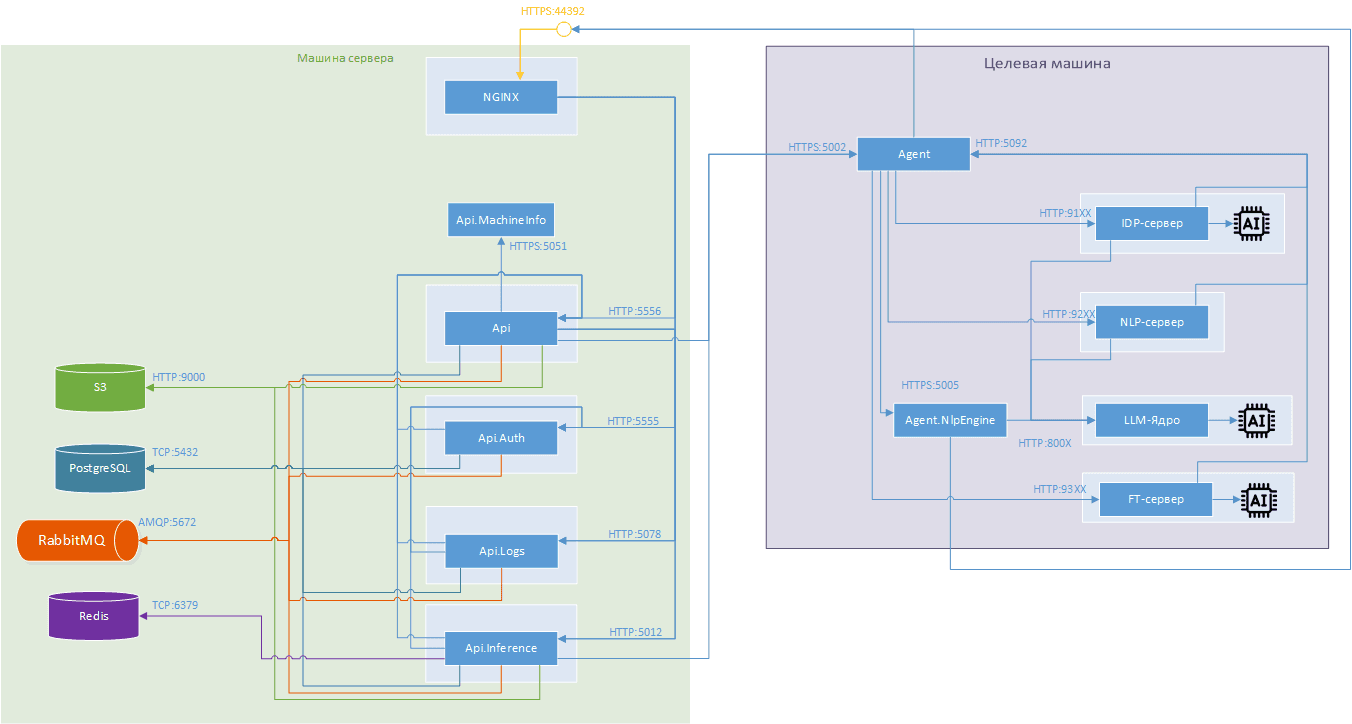

Компоненты AI Server и их связи с целевыми машинами приведены на схеме ниже:

Целевая машина — физическая или виртуальная машина, на которой производится обучение/инференс ИИ-моделей AI Server.

| Наименование | Компонент AI Server | Запуск | Кол-во | Docker | Стандартные порты | Лицензируется | Роль |

|---|---|---|---|---|---|---|---|

| Агент | * | systemd | 1 | Нет | https: 5002, http: 5092 | Да | Взаимодействие серверной части AI Server с другими компонентами Целевой машины; Управление жизненным циклом IDP-сервера, FT-сервера и NLP-сервера |

| IDP-сервер | Умный OCR | Агент | 0..N | Да | http: 9100..9199 | Нет | Обучение и инференс CV-моделей |

| NLP-сервер | NLP | Агент | 0..1 | Да | http: 9200..9299 | Нет | Непосредственное взаимодействие с LLM-моделями |

| FT-сервер | NLP | Агент | 0..N | Да | http: 9300..9399 | Нет | Файнтюнинг моделей |

| Агент LLM-ядра | AI Текст | systemd | 1 | Нет | https: 5005, http: 5095 | Нет | Управление жизненным циклом LLM-ядра |

| LLM-ядро | AI Текст | Агент LLM-ядра | 0..1 | Да | http: 8000..8009 | Нет | Инференс LLM-моделей |

Целевых машин может быть несколько. Например, для Умного OCR можно использовать отдельную от NLP целевую машину. На каждой целевой машине при этом должен быть свой агент (требует отдельной лицензии).

Не рекомендуется размещать на машине с LLM-ядром другие ресурсоёмкие приложения.

Открытие портов описывается далее в статье Установка

агента. В

частности, порт 5002 сервиса “Агент” должен быть доступен для вызова со

стороны сервера. Порт 5092 сервиса “Агент” должен быть доступен для вызова из

подсети agent_agent_ai. Остальные порты не должны быть доступны за пределами

сервера.

Для настройки целевых машин нужна чистая машина с ОС Linux (обязательно с последними обновлениями). На машину необходимо скопировать папку с комплектом поставки.

Для настройки целевых машин требуется последовательно выполнить все шаги настоящего руководства.

*Сетевая папка, доступная с машины, на которой размещен комплект поставки.

Системные требования

Для целевых машин следует использовать рабочие станции под управлением Astra Linux Special Edition / Ubuntu, к которым предъявляются требования из таблицы ниже.

| Компоненты | Вид LLM | CPU | RAM | HDD | GPU | Требования |

|---|---|---|---|---|---|---|

| Умный OCR | - | 4 ядра AVX512 | 8 Гб | 50 Гб | - | Минимальные |

| Умный OCR | - | 16 ядер AVX512 | 32 Гб | 2 Тб | - | Рекомендуемые |

| Умный OCR | - | 16 ядер AVX512 | 32 Гб | 2 Тб | NVIDIA (≥ 16 ГБ, 8.0 ≤ Compute Capability ≤ 12.0, 12.4 ≤ CUDA toolkit ≤ 12.8) | Рекомендуемые, оптимизация обучения |

| NLP | Ollama | 2 ядра AVX512 | 16 Гб | 250 Гб | - | Минимальные |

| NLP | Ollama | 2 ядра AVX512 | 16 Гб | 250 Гб | NVIDIA (≥ 24 ГБ, 8.0 ≤ Compute Capability ≤ 9.0, 12.4 ≤ CUDA toolkit ≤ 12.8) | Рекомендуемые |

| NLP | Ollama | 2 ядра AVX512 | 16 Гб | 250 Гб | NVIDIA (≥ 24 ГБ, Compute Capability 12.0, CUDA toolkit 12.8) | Рекомендуемые |

| NLP | vLLM | 8 ядра AVX512 | 32 Гб | 250 Гб | NVIDIA (≥ 24 ГБ, 8.0 ≤ Compute Capability ≤ 9.0, 12.4 ≤ CUDA toolkit ≤ 12.8) | Рекомендуемые |

Если на 1 целевой машине установлены одновременно компоненты Умного OCR и NLP, то требования суммируются.

Проверить наличие инструкций AVX512 можно командой:

grep avx /proc/cpuinfoЕсли в выводе содержатся только AVX2-инструкции, обработка запросов моделью будет замедлена в разы, или, в зависимости от модели, невозможна. Если в выводе отсутствуют даже AVX2-инструкции, работа с LLM-моделями будет невозможна.

Что дальше

Выполните установку Docker на каждую целевую машину из группы:

После чего можете переходить к установке агента.